超负荷 Google I/O:AI 大满贯更新在前,没人关注 Pixel 手机了

在 AI 上积累了7年的谷歌,迎来了一场真正以 AI 为核心的 I/O 发布会。

比起去年,强调「整合全球信息,使人人都能从访问中受益」的使命, 谷歌 CEO Sundar Pichai 今年 以「Making AI helpful for everyone」总领整个发布会。 AI 将成为工具,帮助每一个人。这既包括了谷歌一贯强调的整合信息、学习,还包括 AI 成为创作力辅助、帮助企业更好地创新产品。

模型、产品、功能、平台、硬件,一个接一个 demo,一个接一个 trailer,掌声和欢呼一刻也没有停下。

如果没有 OpenAI 和微软带来的竞争,我们可能永远看到不到这样一场,超负荷的 Google I/O 发布会。

在这两个半小时里,山景城的海滨露天剧场,渴望成为世界中心。

开场三个 Demo

开场前的表演即是一个生成式人工智能实验。

音乐家丹·迪肯使用谷歌的 MusicLM、Phenaki 和 Bard Al 制作。「在制作这个节目的过程中,没有鸭子受到伤害。」

Sundar Pichai 登台,「机会终于来了,」他说,「这是 AI 的好年」。

在大模型及一系列产品功能更新前,他先上了三碟前菜。

Gmail 发布新功能 「帮我写」(Help Me Write) ,根据邮件内容,用自然语言命令 AI 撰写对应的回复。

比如,航空公司发来航班取消的邮件,表示会送上代金券作为补偿,这时候你可以让 AI 帮你写一个全额退款的邮件,它就会结合具体邮件内容,撰写全文。

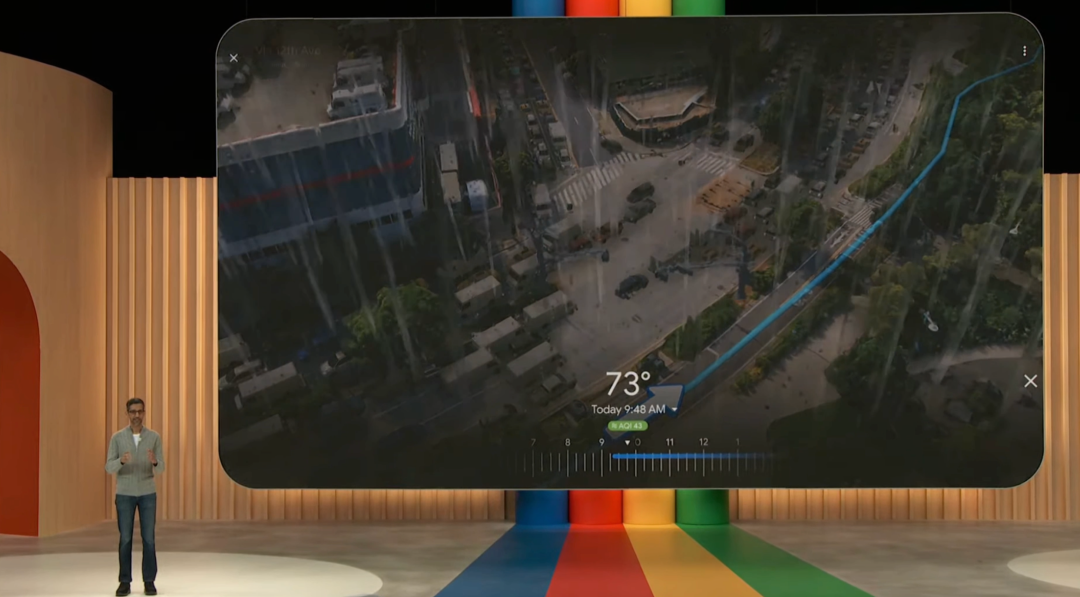

Google Maps 将街景与导航结合,发布新功能「沉浸式路线视图」(Immersive View for routes)。

用户可以在导航时,直接提前看到整个路线的动态街景视角。

在这一视图中,用户还能查看路线中的交通、天气情况。

Google Photos 推出「魔法编辑器」(Magic Editor)。

这是编辑前的图片,仅仅使用拖拽和一键优化,孩子的位置移动了,天空变得更蓝了。

![]()

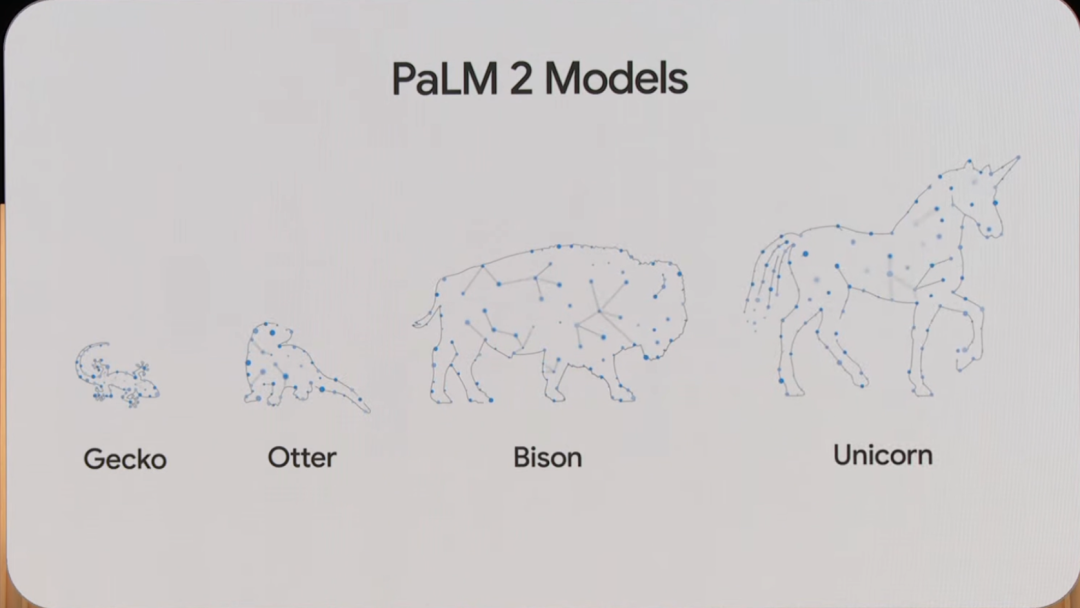

PaLM2 取代了 LamDA,

分化出四个版本

如今谈 AI 技术,必须先亮出大模型,谷歌也不例外。

在 I/O 之前,关于谷歌最新模型的消息就陆续传出。此前支持 Bard 的模型是一个轻量级的对话模型 LamDA,Pichai 在三月份采访中就表示,将把背后的模型升级为更大规模的 PaLM 模型。

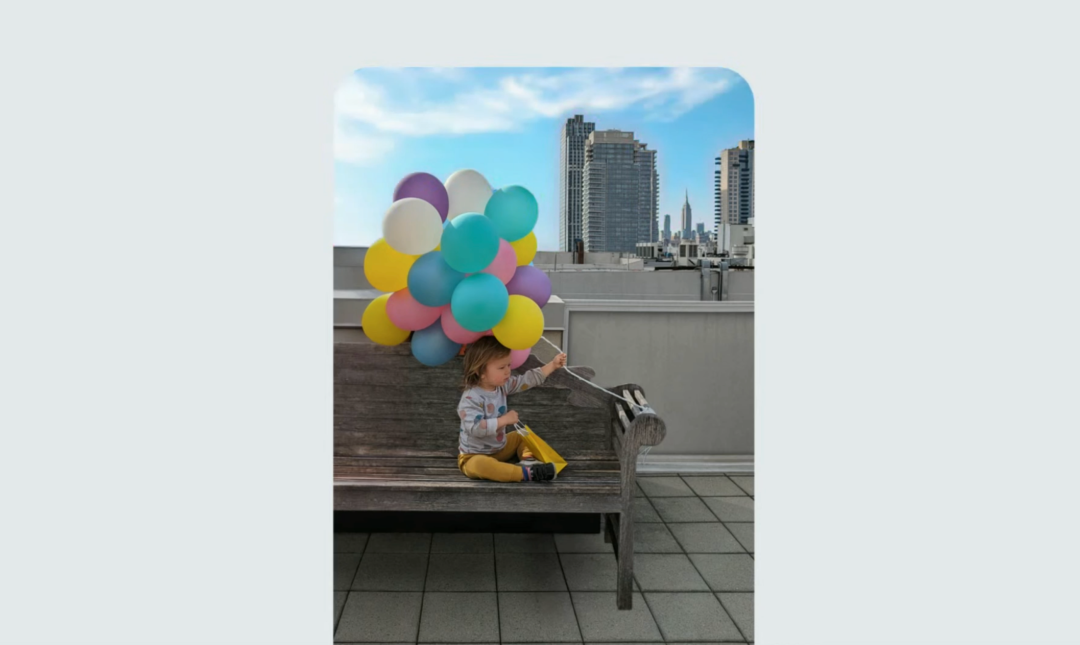

I/O2023 上,最新最强的 PaLM2 终于露出了庐山真面目。PaLM2 是 PaLM1 的升级版。PaLM2 在数学、编码、推理、多语言翻译和自然语言生成上的表现都更加出色。

Pichai 现场展示了一个修改 Bug 后,用韩语对代码进行解释的例子:

PaLM 是谷歌于 2022 年 4 月份推出的大语言模型,有 5400 亿参数。这次介绍的 PaLM2 是在此基础上的升级版。PaLM 是 Pathways Language Model 缩写。可以理解为,在 Pathway 架构上训练的模型。

Jeff Dean 曾经专门撰文介绍 Pathway 架构,这个架构是为了可以处理多任务的通用模型而设计,采用了一种新的异步分布式数据流,这使得并行计算和运行更加高效。Pathways 还可以支持包含视觉、听觉和语言理解的多模态模型。

PaLM2 使用谷歌自主研发的 TPU 进行计算,具体使用了多少算力计算 PaLM2 目前尚未公布,但可以参考训练 PaLM1 的数据,使用了 6144 块 TPU。

使用谷歌最新的 TPU 架构来训练模型,意味着在基础工程上,谷歌进行了 整合计算、优化缩放、改善数据集组合和模型架构等各项工作, 这些也能够使得模型能力灵活被调用进各种产品、服务中。谷歌能够将模型的能力按照需求进行蒸馏和提炼。

为了让模型的能力更灵活地服务于产品,Pichai 特地强调,PalM2 有四种不同的尺寸,分别以动物的名称命名:壁虎、水獭、野牛和独角兽。其中壁虎(Gecko)最轻量级的版本。

Gecko is so lightweight that it can work on mobile devices and is fast enough for great interactive applications on-device, even when offline. This versatility means PaLM 2 can be fine-tuned to support entire classes of products in more ways, to help more people.

Gecko 是如此轻量级,以至于它可以在移动设备上工作,而且速度足够快,可以在设备上运行交互式应用程序,即使在离线时也是如此。这种多功能性意味着可以对 PalM2 进行微调,以便以更多的方式支持整个类别的产品,从而帮助更多的人。

最轻的模型可以在移动设备上运行交互应用程序, 而在最新的三星 Galaxy 上,它能够每秒处理 16 个Token。

此外,pathway 架构的设置,也利于在特定领域对模型进行微调。健康研究团队在此基础上进一步发展,创建了 Med-PaLM 2,它可以检索医学知识、回答问题、生成有用的模板,解码医学行话。

在上一代 AI 视觉技术中,AI 已经被训练能够看懂 X 光片等图像,现在结合语言生成能力,模型能够根据提供的

![]()

搜索新体验:升级 Bard 之外,

又加了一个 Search Lab

之前为了应对 NewBing 的挑战,谷歌匆匆上线了对话机器人 Bard。但是从各种用户反馈来看,许多人都觉得作为搜索助手的 Bard 不如 NewBing 好用。

对话与生成将更新搜索体验,已经成为新的共识,但是具体的产品形态依旧在探索的路上。 谷歌也不想用 Bard 这个产品完全定义自己未来的搜索产品形态, 因此关于搜索功能的升级,Keynote 中分为两个部分来展示:Bard 产品升级,Search Lab 的新功能测试。而这些新的功能,都由最 PalM2 来支持。

Bard 的基本功能点升级比如支持更多语言,能够识别图像信息,都属于规定动作,并无意外。让人感到惊喜的地方是,Bard 将接通谷歌自己的应用程序,以及一些外部的应用,来实现更强大的功能。

比如,有着惊艳语言生成图像能力的 Adobe firefly,在未来几个月将直接集成到 Bard 中。这样在和 Bard 的对话中,就能够设计图片,比如请柬的封面、想象中的蛋糕。

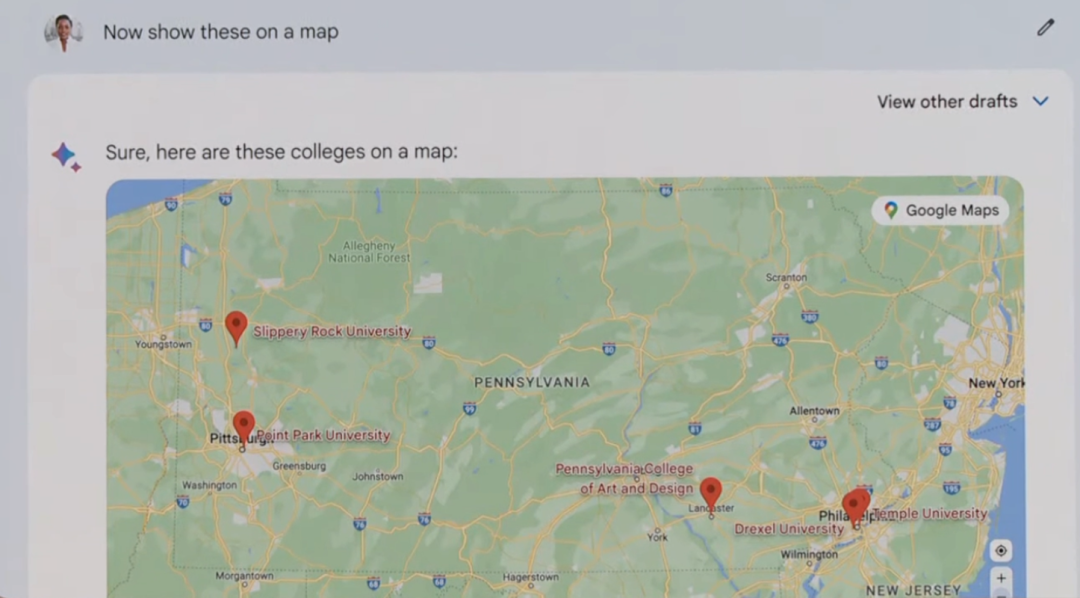

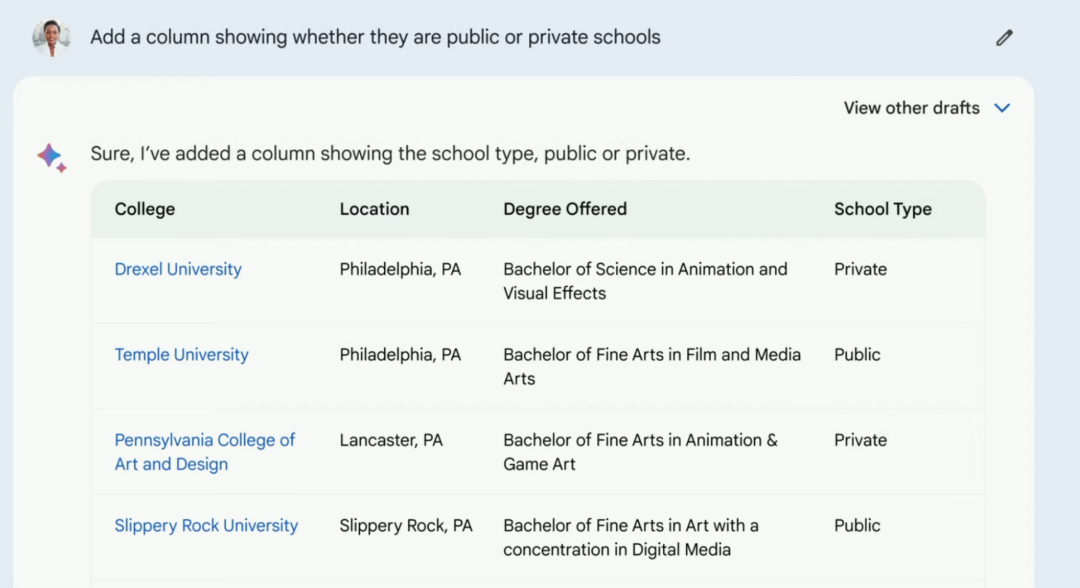

谷歌地图、图表能力也能够直接在 Bard 中调用。现场演示给了一个例子,用户通过提问得到了几所符合自己报考目的大学名单,让 Bard 在地图中将这几个学校的地址标出来,再让 Bard 根据学习的专业、排名、地址等相关信息生成对比表格。

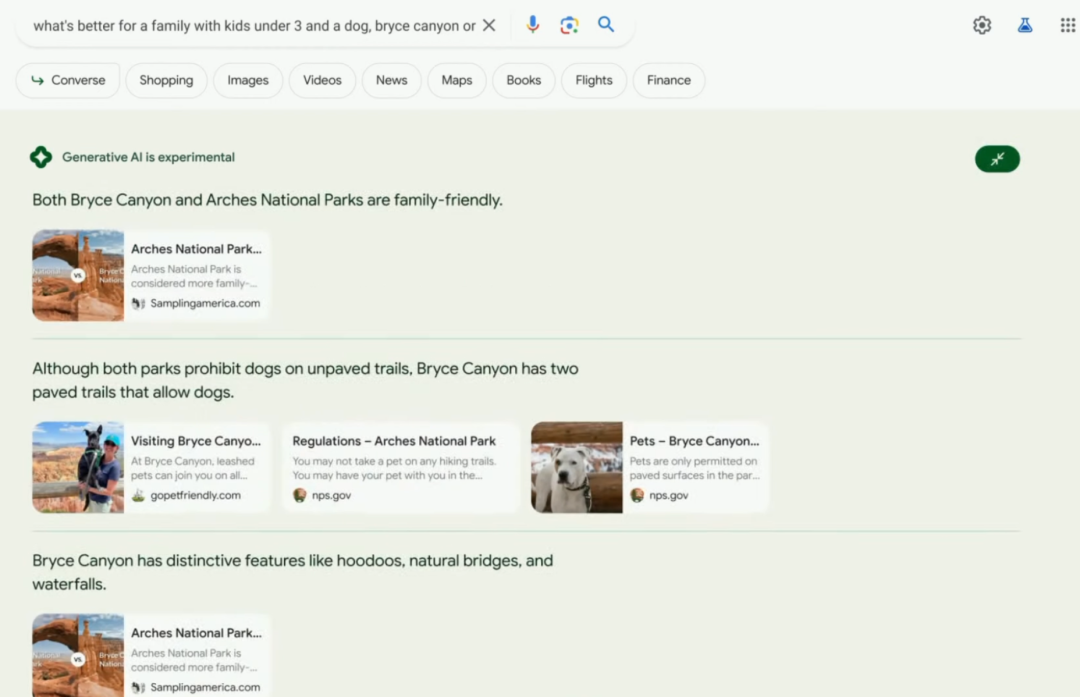

关于复杂问题的搜索,则在 Search Lab 的环节中进行演示。Search Lab 是一个探索性的产品,目前还没有全部开放,需要申请 Waitlist 才能使用。

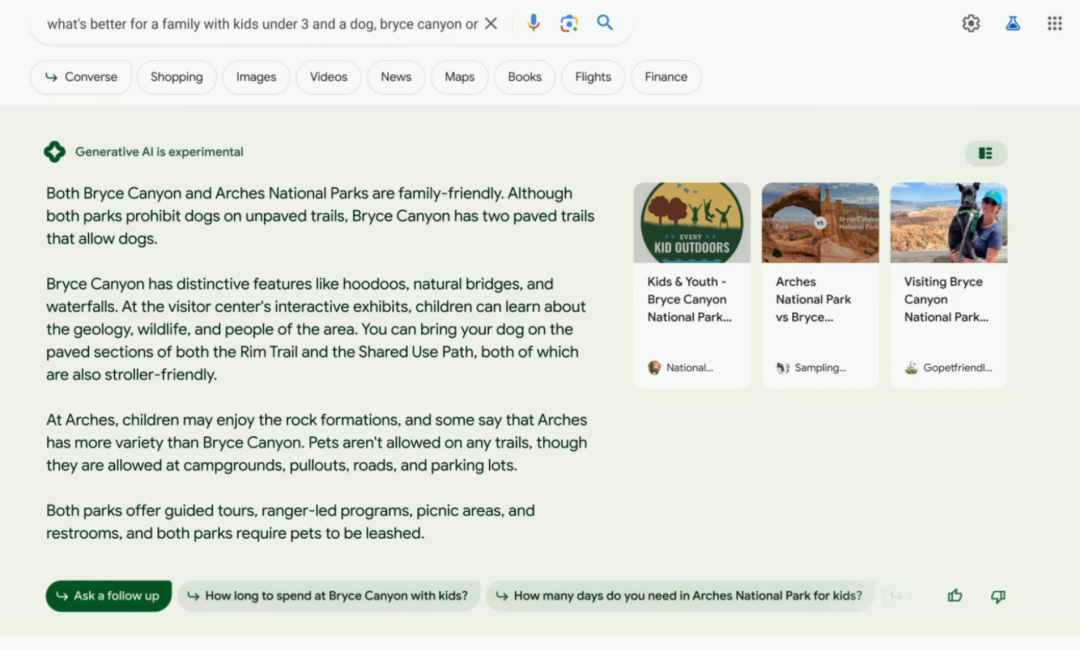

新的搜索体验试图帮助人们更好地分析一个复杂、或者有些模糊的问题。 在人们开始搜索的时候,往往问题并不明确,而是知道一个大致的方向,又或者是问题能够再被拆分为子问题。

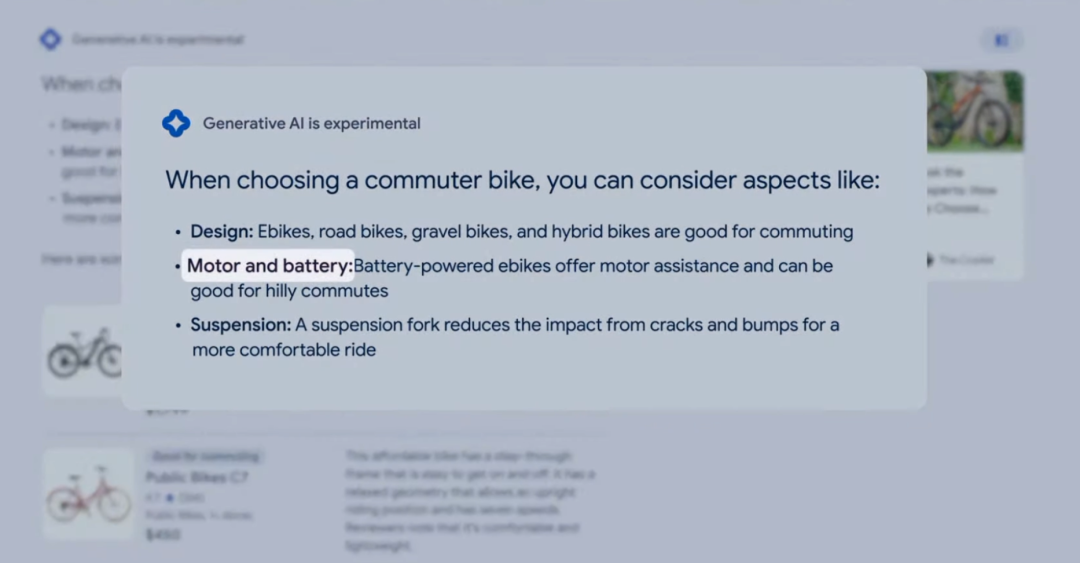

现场演示了对比景点、购买 ebike 两个例子。 搜索即是决策过程, AI 生成要点提供了思考的框架,并提供相关链接,用户可以通过对话深挖信息。

有 3 岁以下的孩子和狗狗的家庭,Bryce Canyon 和 National Parks 哪个更适合?在这个案例演示中,Generative AI 汇总提炼了两个景点的优劣,并且提供了几篇参考链接,如果用户有需求,可以打开参考链接阅读,而且链接文章也会根据不同的内容重点进行分类。

在另外一个演示案例中,用户需要选购一辆支持通勤 5 英里和山路的 ebike, AI 会提炼设计、电池、减震装置等关键的选购因素。

对话模式下, AI 会记住用户之前的一些选择,对信息做进一步的处理。比如用户想要「红色的 Ebike」,AI 会继续基于「通勤 5 英里、支持山路」等条件继续进行筛选。

![]()

谷歌的 AI 副驾驶,叫「Duet AI」

不出意外,有了新模型,对内,能升级的产品升级;对外,向企业提供服务,帮助他们更好地用上模型能力。这也符合 Pichai 在开场后不久提到的「 AI helpful everyone」。

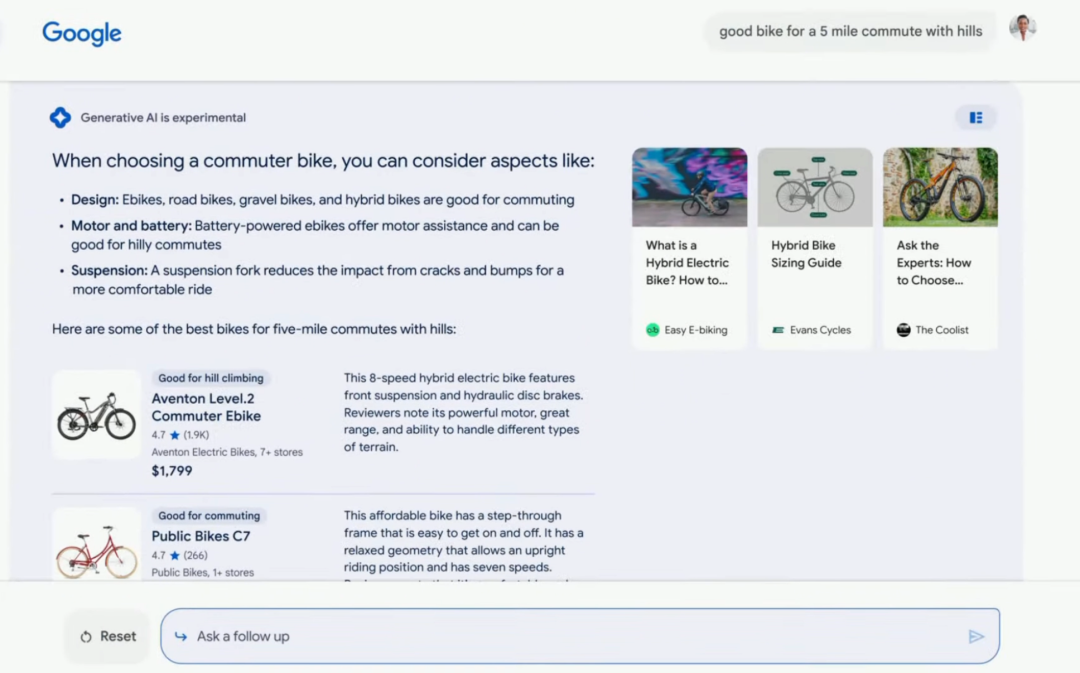

Google Workspace 是谷歌推出的多人协作软件,现在无论是写作文案、故事写作、制作幻灯片、制作表格,都可以用上 AI 了,形式类似于微软的 Copilot,在工作的主界面右侧有一个边栏,谷歌将其称为「sidekick」,AI 会在这里提出文章的修改意见、建议生成配图、表格的样式,用户选择合适的结果,就可以将 AI 生成的内容移入主界面。

「sidekick」样式

「Help Me Write」的写作辅助功能,同时出现在 Workspace 和 Gamil 里。据谷歌介绍,目前在 Workspace 最受欢迎的用例是「给出几个关键词,完成招聘要点」。

阅读室、豌豆荚创始人,同时也是谷歌前员工的王俊煜对此吐槽,这个产品设计就是沿用了 Microsoft 365 Copilot 的思路,但是换了个「Duet AI 」的名字。

形式上看起来的确差不多,不过使用体验如何涉及很多细微的因素,比如根据 prompt 的生成内容是否令人满意,根据文章内容生成的配图效果如何,是不是可以直接使用。这些都需要等待用户们使用了一段时间后,给出反馈。

就像各处出现的「Help Me Write」,「Duet AI 」也出现在给开发者的云工具上,在 Cloud Console 出现的「Duet AI」,功能是用语言改善开发者与云平台上工具的交互体验。利用生成式 AI 提供实时的上下文代码完成、代码函数生成、基于代码库的建议,甚至协助进行代码审查和检查。

![]()

面面俱到的服务:

平台、模型、计算设施

谷歌面向企业的 AI 平台叫做 vertex AI,企业用户可以在这个平台上调用需要的模型、按照需求对模型的参数权重进行微调、根据内部数据建立企业版本的搜索引擎。

除了语言模型,谷歌还提供了其它三个专业能力模型供选用:图像生成模型、代码生成模型、以及文本转语音模型 Chirp。

在现场展示的合作伙伴中,Replit、Character AI 、Canvas 等明星公司都在其中,当然还有谷歌自己投资的 Antropic,也在使用谷歌提供的模型云服务。

现场还公布了一个基础设施层面的消息,谷歌和英伟达合作,搭建了基于 H100 的下一代 A3 图形处理器 超级计算机。

基于 H100 的 A3 虚拟机,网络带宽比上一代 A2 虚拟机多 10 倍。当然,PalM 的 API 也将在不久开放。

可以说,在对外输出模型能力上,谷歌确实拿出了实力雄厚的大厂做派,从开发工具平台、到基础模型、到基础设施、开放 API ,一整个做了全套。

![]()

硬件:三款新产品,

Android 14 未登场

这次 I/O 大会上 Google 也发布了一系列的硬件。除了在 2022 I/O 上预告的 Android 平板、新机 Pixel 7a,谷歌也终于发布了自己的折叠手机。

今年 5 月 4 日星战日,Google 的一段视频泄露了折叠手机 Pixel Fold 的存在。

对标三星的 Galaxy Z Fold 系列,目前有黑白两种配色,官方价格 1799 美元,已同步上架,预定送 Pixel Watch,6 月开始配送,默认不包含充电器。

为了实现折叠的形态,谷歌重新设计了长焦镜头模组、电池组件等等,使其保持相对的轻薄,官方号称是最薄的折叠屏手机。

双屏除了我们常见的桌面模式和悬停模式之外,谷歌考虑的「内外屏」同时显示功能是『实时翻译』,内外屏显示两种翻译的语言(感觉并不是什么有用的功能,语音翻译不是更实用?)。

![]()

总结

在微软的 NewBing、Office 365 全家桶、Notion AI 辅助写作功能面世之后,再看谷歌的产品似乎都给人一种似曾相识之感,很难耳目一新。大模型给产品形态上带来的第一轮冲击,已经基本完成了。

值得注意的是,虽然产品展示了识别图片的能力,但是谷歌似乎还没有一个像 GPT-4 这样的拥有文字、图像多模态的基础模型。Pichai 只是预告了一个叫做 Gemini 的多模态模型,正在研发之中,不久后会公布。

抛开 Duet AI 与 Copilot 类似的产品形态,谷歌在介绍时,强调了其自动优化 Prompt 语言表述,以及自动根据文章内容提出写作建议的特点,似乎更加用户友好。是否用起来也会如此,还需要等待用户反馈。同理,最新的模型 PaLM2 所支持的搜索功能,和 NewBing 相比,究竟体验如何?PaLM2 支持的 Bard,比之前 LamDA 支持的 Bard,使用感能够提升多少?

在 I/O 的媒体预沟通会上,有人提问,看起来谷歌将模型的能力分散到了各个产品里,重点不明确。来自谷歌研究部门的工作人员回答道,「这似乎是一种分散策略,但在谷歌,我们支持大量的产品,我们将其视为模型的灵活性,来支持不同的用例和受众群体。这也是我们能够同时在许多不同方向上测试模型能力的好方法。」

长期来看,大模型的最终竞争壁垒不在于技术,而在于产品是否会被用户真正接纳,围绕技术能否实现开发者生态。 从这次发布来看,谷歌布局了所有能布局的产品与服务,而在其进入的领域中,是否能够真正形成优势,所有人将拭目以待。