让大模型“看得懂”,腾讯混元多模态图文理解模型居全球第一梯队

2024 年以来,大模型测评领域也有新变化,为了避免“刷榜”,大模型测评机构推出“角斗场”(Arena)模式,采用随机选择模型“打擂台”的形式,面向用户开放,通过直接的提问命令和打分累计进行排名,以衡量模型能力,有效反应模型在真实应用场景中的表现。

图:智源FlagEval大模型角斗场多模态模型测评界面

在最新公布的FlagEval大模型角斗场榜单上,腾讯混元多模态图文理解大模型凭借出色的表现,位列国内大模型第一,并且在两个榜单上均与GPT4o 以及 claude 等模型同列第一梯队。

智源研究院发布的FlagEval大模型角斗场榜单

FlagEval大模型角斗场由北京智源研究院推出,接入了全球主流的大模型,并对这些模型进行长期的观察和测评。

腾讯混元是国内首个基于MoE架构的多模态大模型。在架构、训练方法和数据处理方面进行了创新和深度优化,支持任意长宽比及最高 7K 分辨率图片的理解。与大部分多模态模型主要在开源基准测试中进行调优不同,腾讯混元多模态模型更加注重模型的通用性、实用性和可靠性,具备丰富的多模态场景理解能力。

应用方面,腾讯混元多模态理解模型面向通用场景和海量应用进行了优化,积累了数千万相关问答语料,涵盖图片基础理解、内容创作、推理分析、知识问答、OCR 文档解析、学科答题等众多场景,可以完成描述图片内容、将图片转换成文本表格、解释一段代码、分析账单、做数学题等任务。这些能力已经在腾讯元宝APP 上线,并可以通过腾讯云的API调用,除了这次纳入评测的Hunyuan-vision模型,还包括上个月新发布的旗舰多模态理解模型Hunyuan-turbo-vision,具有更强大的能力。

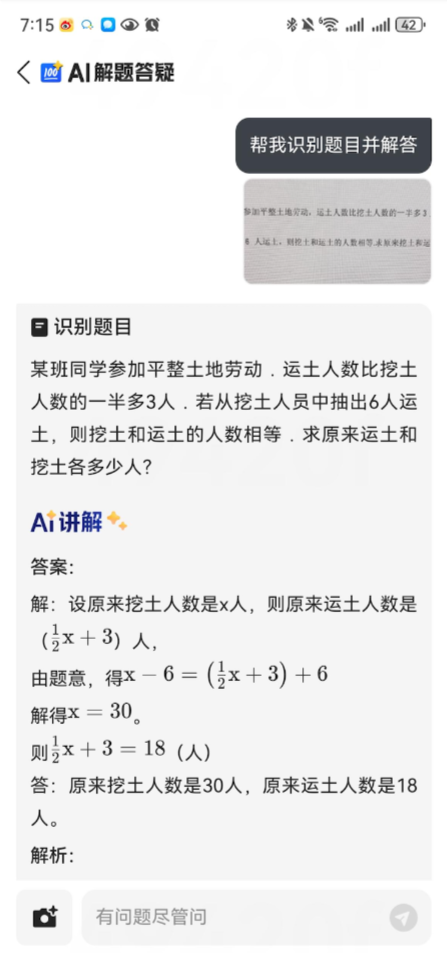

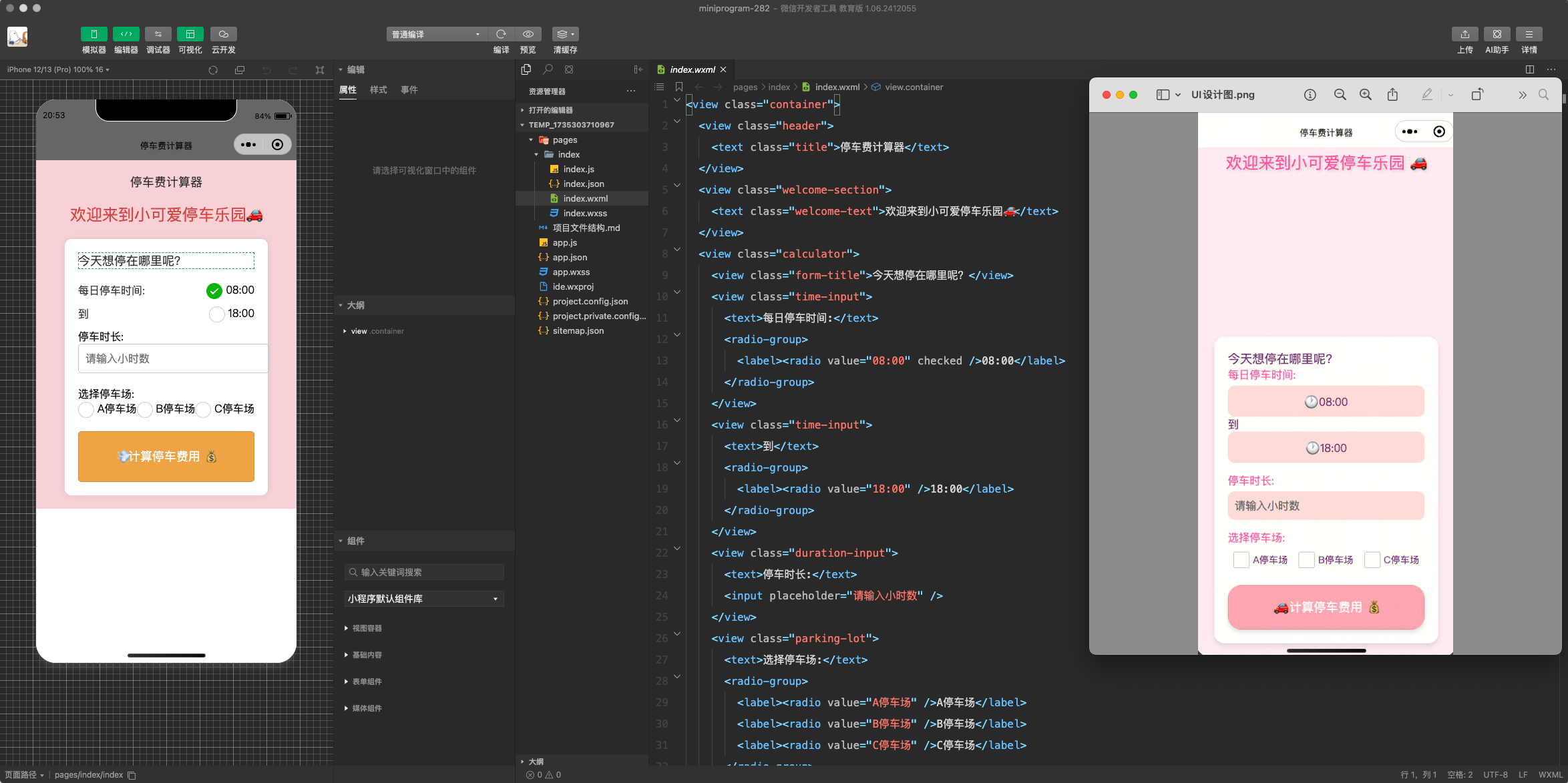

作为实用级大模型,腾讯混元多模态理解模型目前已经在腾讯的业务场景中取得广泛应用,其中包括QQ、QQ浏览器、腾讯文档、腾讯 游戏 、腾讯广告、 微信 读书、微信小程序等。例如,在QQ说说里,可以实现自动为照片配文,在QQ浏览器里,可以通过输入照片,让AI自动识别图片并答题,在小程序教育平台中,可以通过根据图片自动写程序,提升开发效率。

此外,在腾讯广告场景中,腾讯混元大模型强大的内容理解能力,为广告个性化推荐、广告定位及效果预测提供了有力的支持,提升广告精准度和用户浏览体验。

QQ说说AI配文

QQ浏览器AI解题答疑

小程序教育平台-看图写小程序

多模态理解模型能够同时处理和理解多种模态信息,实现更全面、更深入的语义理解,它通过整合不同模态的信息,提高了AI在复杂任务中的表现,也为人工智能领域带来了新的机遇。未来,随着模型能力的不断升级,腾讯混元多模态理解模型也将推出更多大模型图片搜索、图片审核以及视频理解等多个领域的深度应用。