可令AI自我判断输出内容正确性,谷歌公布模型训练框架ASPIRE

1 月 23 日消息,谷歌日前发布新闻稿,介绍了一款专为大语言模型设计的 ASPIRE 训练框架,该框架号称可以增强 AI 模型的选择性预测能力。

谷歌提到,当下大语言模型在自然语言理解和生成内容方面发展迅速,已被用于构建各种创新应用,但要应用于高风险决策类场合依然不妥。这是由于模型预测具有不确定性及“幻觉”可能,因此谷歌开发了一款 ASPIRE 训练框架,为系列模型引入了“可信度”机制,即 —— 模型会输出一系列答案,每个答案都会具有正确概率评分。

图源 谷歌新闻稿(下同)

在技术层面,IT之家注意到该训练框架主要分为三阶段,分别为“特定任务调整”、“答案采样”和“自我评估学习”。

其中“特定任务调整”阶段是对已接受过基础训练的大型语言模型进行深入训练,专注于强化模型的预测能力。研究人员主要为模型引入一系列可调参数,在特定任务的训练数据集上微调预训练语言模型,从而提升模型预测性能,让模型能够更好地解决特定问题。

第二阶段为“答案采样”,经过特定微调后,模型可以利用先前学习到的可调参数,为每个训练问题生成不同的答案,并创建用于自我评估学习的数据集,生成一系列可信度较高的答案。研究人员同时使用 “集束搜索(Beam Search)”方法及 Rouge-L 算法来评估答案的质量,并将生成的答案及评分重新输入给模型开启第三阶段。

而在第三阶段“自我评估学习”中,研究人员为模型添加一组可调参数,专门用于提升模型自我评估能力。该阶段的目标是让模型学会“自己判断输出的答案准确性”,从而让大语言模型在生成答案时,还会附上答案的正确概率评分。

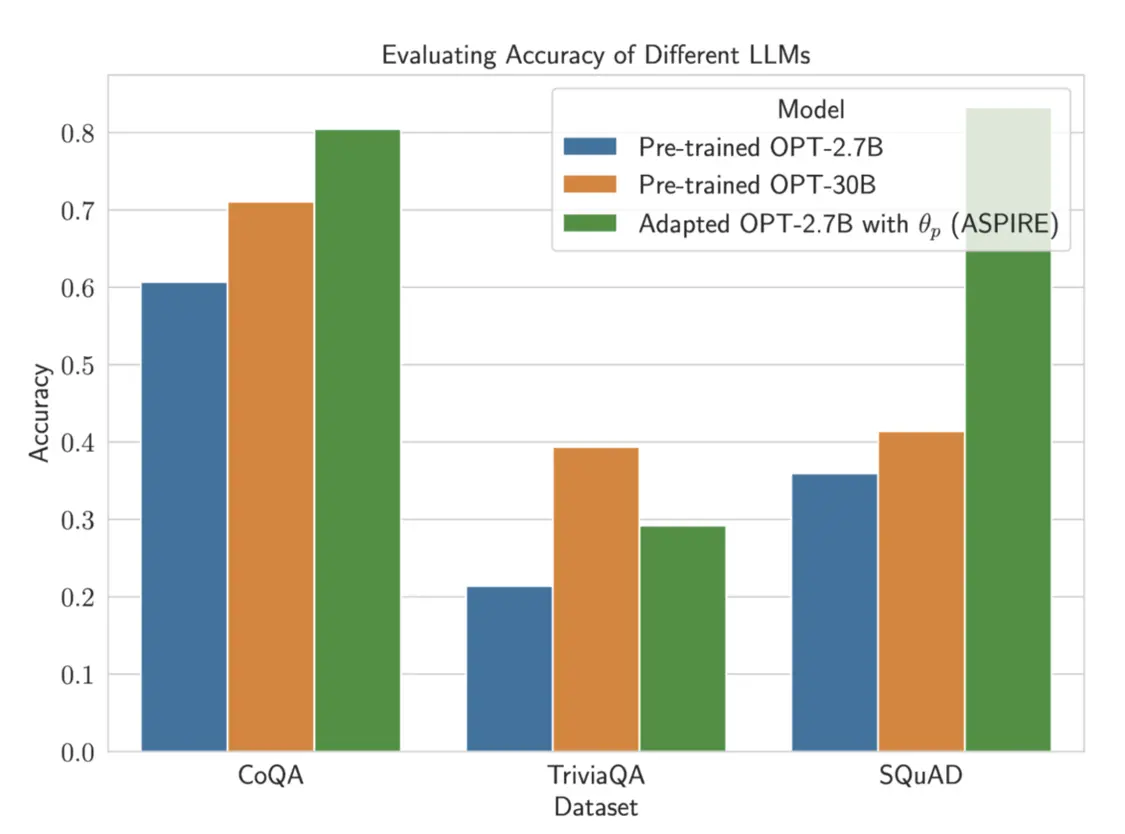

谷歌研究人员使用 CoQA、TriviaQA 和 SQuAD 三个问答数据集来验证 ASPIRE 训练框架的成果,据称“经过 ASPIRE 调整的 OPT-2.7B 小模型,表现远超更大的 OPT-30B 模型”。而这项实验结果也同时表明,只要经过适当的调整,即使是小语言模型,在部分场景下也可以超越大语言模型。

研究人员总结称,ASPIRE 框架训练能够显著提升大语言模型输出准确率,即使是较小的模型,也可以在经过微调后进行“准确且有自信”的预测。

【来源: IT之家】