只需三步,在 CoresHub 上搭建你的 AI 大模型应用

人工智能已进入大模型时代,ChatGPT 已不再一家独大,各种生成式大模型纷纷开源。基于开源模型制作定制化的落地应用成为开发爱好者研究的新方向,基石智算不仅提供 AI 算力的支持,还支持大模型应用开发部署,只需三步就能让开发者构建属于自己的 AI 应用。平台不仅内置了主流的通义千问、Llama、百川等主流开源大模型,还支持用户私有模型上传,快来搭建属于你的 AI 应用吧。

第一步 注册基石智算平台账号

注册并登录 coreshub,完成认证,立即获得最高 500 元算力券!

第二步 模型部署

方式一 模型广场模型

1、平台内置主流模型,可以在模型广场选取模型进行部署

2、点击模型部署后,选取对应算力资源

方式二 私有模型

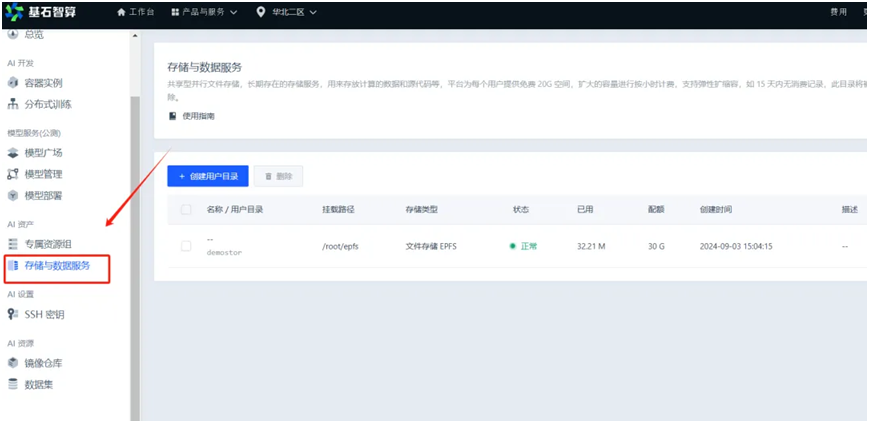

1、将本地私有模型上传到 “存储与数据服务”

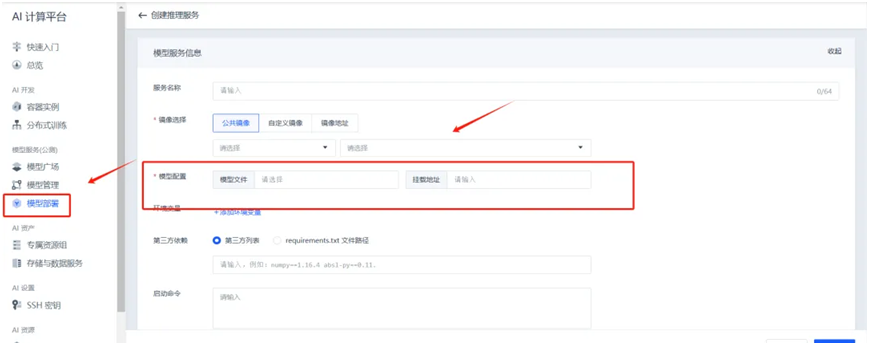

2、点击模型部署,创建推理服务,进行模型文件上传

创建推理任务

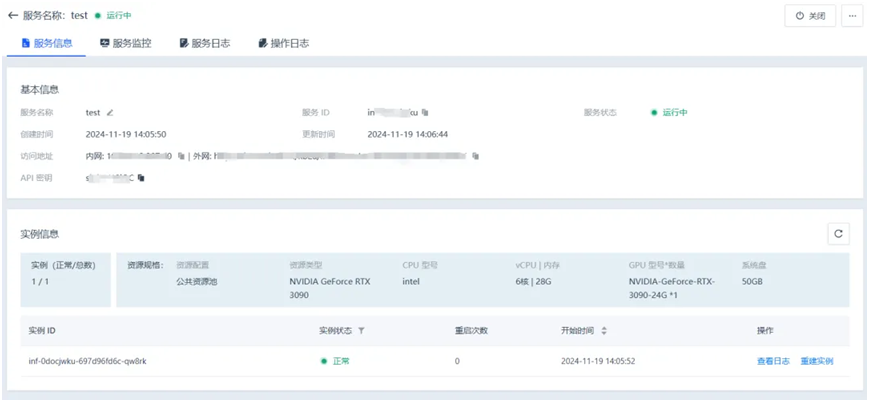

点击创建推理任务,进入推理服务详情页面,在服务信息页签内,获取外网访问地址和 API 密钥。

第三步 模型调用

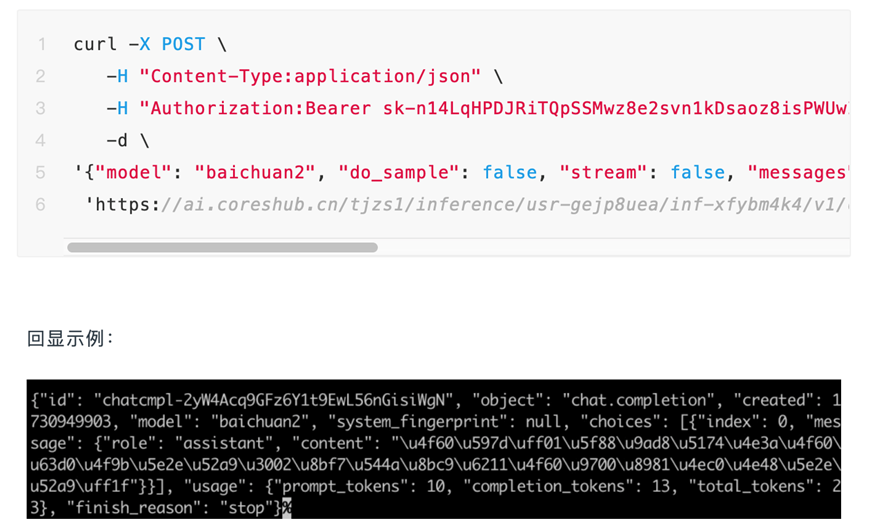

方式一 手动调用

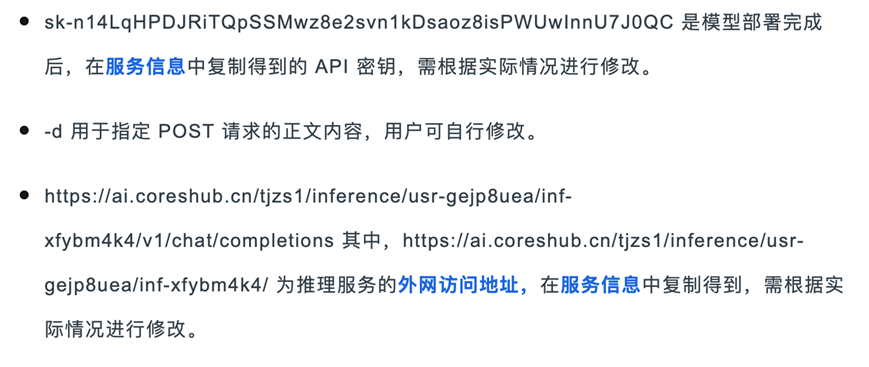

1.模型部署完成后,用户可打开本地电脑终端。

2.执行如下命令,直接发送 HTTP POST 请求。

方式二 集成架构的方式调用

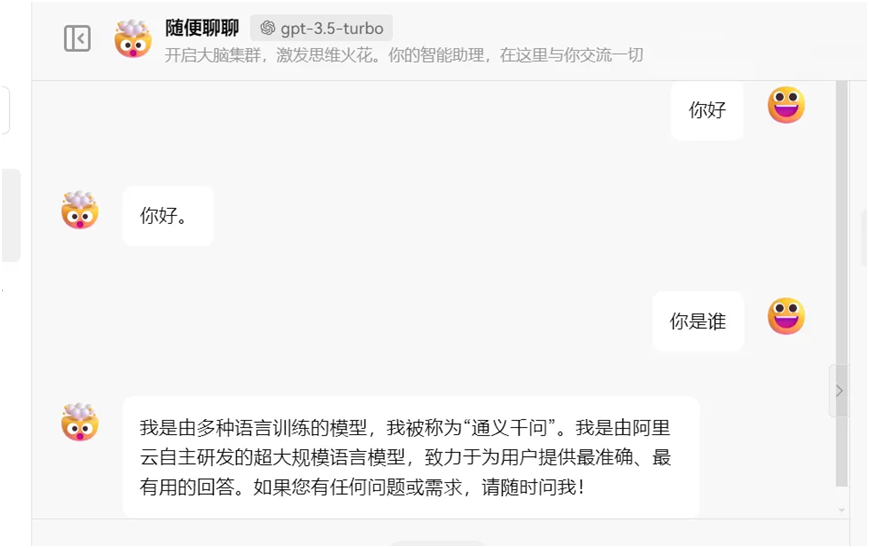

1、开启第三方工具,配置相应参数,检查连通性。以使用 OpenAI 为例,其他工具请用户自行参考相应的官方说明。API 代理地址:为推理服务的外网访问链接,用户需根据相应服务生成的外网链接自行修改。

2、API 连通性检查完毕后,即可实现回话功能。

方式三 临时调用

推理服务的外网访问链接生成后,可直接通过修改外网链接的方式,使用浏览器使用大语言模型。

1.完成模型部署,获取外网访问链接。

2.将外网访问链接中的 inference 字段修改为 inference-web。

3.在浏览器中输入修改后的外网链接,即可直接使用。