麻省理工学院新研究:绷紧肌肉就能操控无人机,比摇杆更省事

来源:智东西

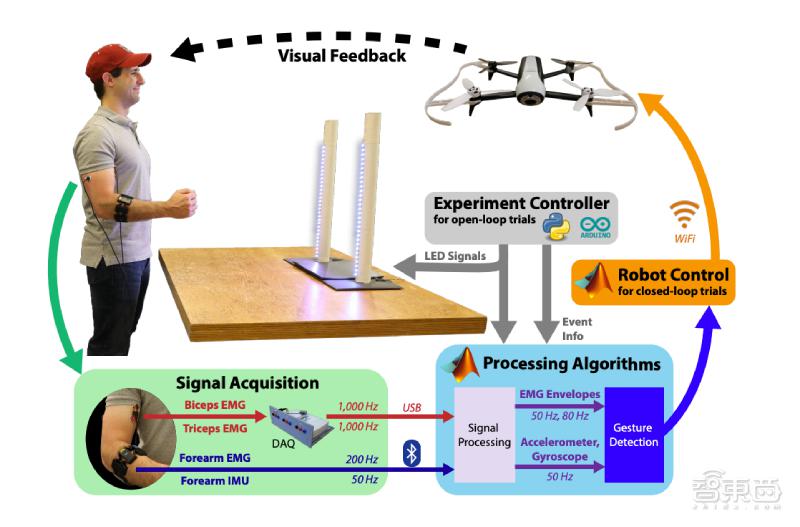

近日,麻省理工学院计算机科学与人工智能实验室(CSAIL)的研究团队利用肌肉传感器和运动检测算法,开发出一个“行为控制机器人”系统,能通过肌肉收紧来远程遥控无人机。

目前,搭载这个系统的无人机能够对 8 种手势做出反应,反应正确率达到 81.6%。

利用机器人完成工作可以解放人类的生产力。要达到这一目的,需要机器人和人之间达到较高的配合度。此前的研究从语音识别、自然语言处理、计算机视觉、触觉、手势等角度进行了探索。结果显示,语音、触屏控制不够灵敏,已有的传感器系统也比较笨重。

麻省理工学院的研究人员认为让机器人理解人类的非语言指令可以解决这些问题。据此,他们研发出一款端到端手势控制系统。这个系统用肌电信号传感器接收用户手势,用算法判断指令内容,不需要进行繁琐的数据训练或校准,配套传感器的尺寸也比较小。

这项研究已经入选 2020 年人机交互国际会议(ACM/IEEE HRI),这是人机交互领域最重要的会议之一。

论文发表在计算机学术网站 ACM Digital Library 上,论文题目为《使用肌肉和动作传感器实现即插即用手势控制(Plug-and-Play Gesture Control Using Muscle and Motion Sensors)》。

论文链接:https://dl.acm.org/doi/10.1145/3319502.3374823

一、用传感器捕捉肌电信号,设备更轻巧

肌电信号与人体的运动意图相关。根据之前的研究,肌电信号和相关肌肉动力学之间的建模可被用于提升外骨骼、假肢等辅助机器人的性能。

本项研究中,研究人员尝试利用肌电信号传感器(也称肌电图传感器,EMG),将人类手部运动时的肌电信号传输给机器人。

用表面肌电电极从参与者的右上臂提取肌电信号,在肱二头肌短头和肱三头肌长头上放置 24mm 预涂导电胶的 Covidien 电极。前臂上的装置包括肌电图电极和一个惯性测量设备(IMU,由一个加速度计和一个陀螺仪组成)。

可穿戴式肌电信号传感器会差异化增强收集到的每对肌电信号。数据收集系统以 1KHz 的频率对肌电信号进行采样,并通过 USB 把它们传输到可视化仿真工具 Simulink R2018b。

▲传感器捕捉肌电信号的过程

论文指出,使用肌电信号传感器有几个好处:

首先,降低了模型的复杂性。不需要照相机等动作捕捉设备,设备更轻巧;

其次,排除了遮挡、环境噪音等因素的干扰;

另外,肌肉信号能够反映出肉眼观测不到的运动状态(比如关节僵硬),有助于提升人机交互系统的灵活性。

▲“行为控制机器人(Conduct-a-Bot)”系统

二、用算法理解手势含义,实现即插即用

根据论文,让机器人理解手势指令有两个好处。首先,相比于连续运动,手势有助于增加系统的稳健性;其次,这种设计可以减少需要的电极数目,降低了模型的复杂性,增加了可部署性。

研究人员共设计了 8 种手势,分别是:手臂僵直、转动(分为顺时针转动和逆时针转动)、握拳(分为左手、右手、向上、向下)、手腕弯曲和伸展。

对于大多数手势引起的肌电信号,研究人员使用自适应在线聚类算法(Online clustering for adaptive thresholding)帮助机器人理解。

最初,所有的观察结果都储存在未知缓冲区。几秒钟后,高斯混合模型(GMMs,Gaussian Mixture Models)会对数据流分类,并将其添加到相应的滚动缓冲区中。

相比于离线训练方法,自适应在线聚类算法不储存所有的历史数据,不需要大量的校准、训练过程,可以做到即插即用。高斯混合模型(GMMs,Gaussian Mixture Models)会持续更新,聚类数据流并创建自适应阈值。这样,系统就可以适应不同用户的使用习惯。

对于那些很难用自适应阈值来描述的手势(在上、下、左、右四个方向上的握拳动作),研究人员用一个神经网络来帮助系统理解。这个神经网络用过去收集的一些受试者数据进行训练。

通过这两种方法,最终每个集群的训练池中都包含至少 25% 的手势。使用固定的覆盖率有助于保持原有的手势分类。

三、测试 1200 次,分类器识别准确率达 97.6%

在测试阶段,研究人员按照这样的顺序给出指令:转动,手臂僵直,向上、下、右握拳,向左握拳。分类器优先按照最近 0.2s 内检测到的手势做出反应,其次按照根据肌电信号预测到的运动意图做出反应。

研究人员安排 6 名参与者做出 1200 次命令手势,以此评估分类器的性能和界面效率。根据统计结果,分类器对手势动作的识别准确率达到 97.6%。

▲分类器分类准确率

根据肌电信号预测运动意图方面,分类器对于向上握拳的预测准确率最高,达到 100%;对向左握拳的预测准确率最低,为 80%。

▲分类器预测准确率

另外,研究人员把这个系统应用于一个Parrot Bebop 2 无人机。该无人机尺寸大约为 35*43cm,重 500g。在 119 分钟的飞行时间中,测试人员随机做出 1535 个命令手势,无人机在 81.6% 的情况下做出了正确反应。

结语:未来机器人或能识别更多手势

麻省理工学院计算机科学与人工智能实验室的研究团队设计出的“行为控制机器人”系统有效提升了人机交互的效率。论文中写道:“(我们)提出的方法在改善真实场景中的人机协作方面迈出了一步。这种协作越来越普及,会带来更多效益。”

研究人员表示将继续研究,致力于使机器人理解更多手势,并尝试提升传感器性能,捕捉到更精细的肌电活动。