北大清华等联合发布LLaVA

11 月 19 日消息,由北京大学、清华大学、鹏城实验室、阿里巴巴达摩院以及理海大学(Lehigh University)组成的研究团队,最新推出了 LLaVA-o1,这是首个具备自发性(Spontaneous,具体解释可参考文末)、类似于 GPT-o1 的系统性推理视觉语言模型。

LLaVA-o1 是一种新型的视觉语言模型(VLM),其设计目标是进行自主的多阶段推理。

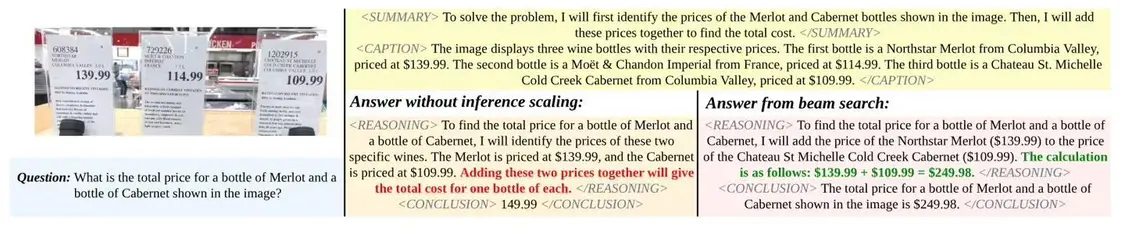

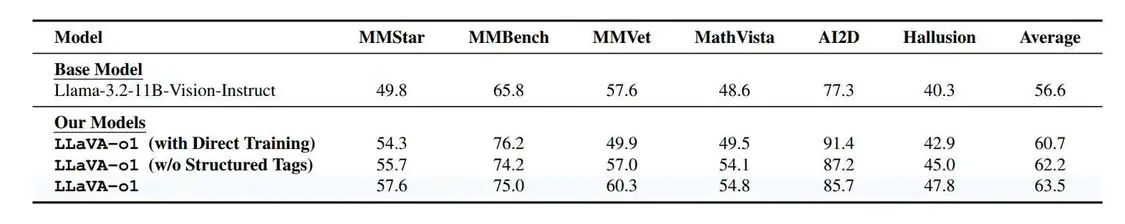

LLaVA-o1 拥有 110 亿个参数,基于 Llama-3.2-Vision-Instruct 模型开发,设计了总结(summary)、描述(caption)、推理(reasoning)和结论(conclusion)4 个推理阶段。

该模型使用名为 LLaVA-o1-100k 的数据集进行微调,该数据集源自视觉问答(VQA)来源和由 GPT-4o 生成的结构化推理注释。

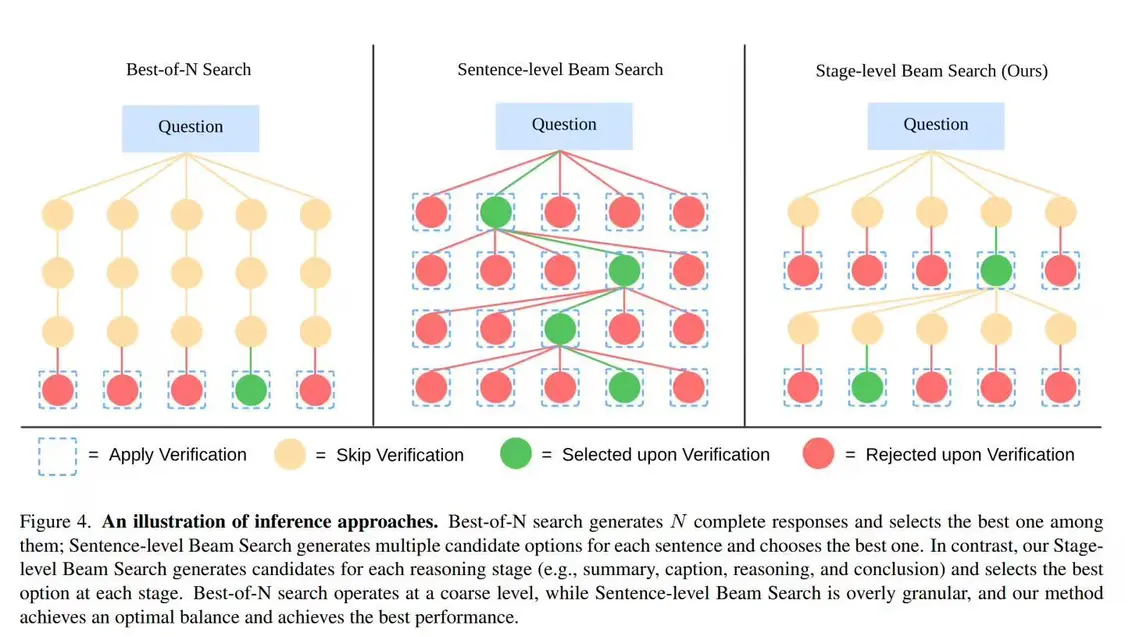

LLaVA-o1 采用了阶段级束搜索(stage-level beam search)的推理时间 Scaling 技术,能够在每个推理阶段生成多个候选答案,并选取最佳答案。

该模型在处理复杂任务时具备较强的能力,在复杂视觉问答任务中,可以突破传统视觉语言模型的局限性。

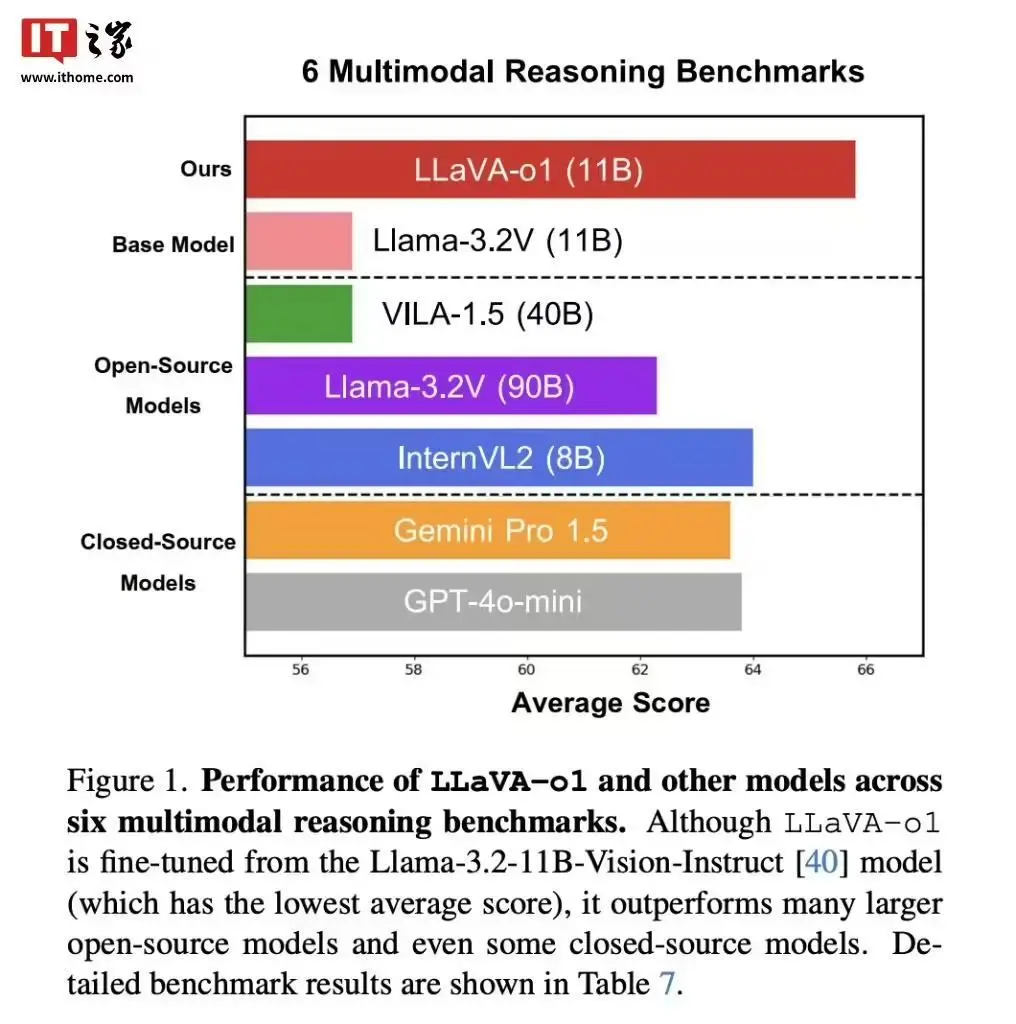

与基础模型相比,LLaVA-o1 在多模态推理基准测试中提高了 8.9% 的性能,超过了许多大型和闭源的竞争对手。

LLaVA-o1 的推出填补了文本和视觉问答模型之间的重要空白,在多个基准测试中的优异表现,特别是在数学和科学视觉问题的推理领域,展示了结构化推理在视觉语言模型中的重要性。

自发性人工智能(Spontaneous AI)是指能够模拟动物自发行为的人工智能系统。这种技术的研究主要集中在如何通过机器学习和复杂的时间模式设计出具有自发行为的机器人或智能系统。

【来源: IT之家 】