公众号/

编译 | 绿萝

不同学科对大脑的理解各不相同,这对我们描述大脑功能的能力提出了挑战。

8 月 16 日,美国桑迪亚国家实验室(Sandia National Laboratories,SNL)计算研究中心神经探索与研究实验室的研究人员在《Nature Communications》发表题为《The brain’s unique take on algorithms》的 Comment。

在这篇评论中,研究人员讨论了桥接自上而下算法和自下而上物理方法的新兴理论计算框架,如何适合于指导神经计算技术(如神经形态硬件和 AI)的发展。此外,研究人员讨论了如何需要这种平衡的视角来纳入神经生物学细节,这些细节对于描述心理健康和神经系统疾病中的神经计算中断至关重要。

论文链接:https://www.nature.com/articles/s41467-023-40535-z

了解大脑计算的基础对于推进计算和治疗神经系统疾病至关重要。尽管现代 AI 取得了越来越多的成功,但生物智能仍然是无与伦比的,并且在许多认知任务中的能源效率要高出几个数量级。与此同时,一些脑部疾病可以被视为计算疾病,我们未来治疗它们的能力要求我们有能力操纵和修复这些计算。因此,了解大脑的计算可以满足现代社会的两个重要需求:能源效率和心理健康。但事实证明,实现这一目标具有挑战性。

这一挑战的核心是如何处理神经计算,不同的社区要么采用自上而下的方法来设计具有适度大脑启发的算法,例如人工神经网络(ANN),要么采用自下而上的方法,计算硬件被设计成模拟大脑的物理特性。例如,近年来,人工神经网络和其他人工智能方法(在实现上主要是线性代数)已经表明,大脑的许多特征可以成功地融入到传统的算法框架中。尽管如此,虽然人工神经网络是描述大脑计算的卓有成效的框架,特别是在感觉系统中,但使用针对图形处理单元 (GPU) 优化的算法来有效描述大脑的各种计算仍然存在尴尬,其中许多计算并没有立即被当前的人工智能很好地描述。自下而上的神经计算方法在不同的方向取得了进展,神经形态硬件的几种方法通过关注生物大脑的特定方面来优先考虑能源效率,包括脉冲通信、模拟计算、内存处理和局部学习。

不方便的是,神经生物学的许多方面尚未在人工智能算法或神经形态硬件中得到充分实现。这些神经科学关注的领域包括广泛的时空尺度的学习、普遍存在的随机性、神经元类型和参数的多样性和异质性、神经调节和发育。今天的神经形态硬件很少考虑这种复杂性,因为没有任何算法可以随时利用它,并且算法同样不会利用这种复杂性,因为它在当今的硬件上效率低下。我们从神经科学中得知,其中许多特征对于理解人类认知和疾病至关重要。例如,血清素和去甲肾上腺素等神经调节剂是大脑灵活性和学习的关键,也是许多精神疾病的根源,但从计算角度来看,这些神经调节剂在很大程度上仍未得到探索。

理论计算机科学为我们提供了方便的工具来帮助解决一些不确定性。阐明不同计算方法之间的区别是计算复杂性理论的基础,该理论广泛地寻求理解不同且通常是奇异的计算模型的能力和局限性。复杂性理论中一些最著名的成果源于认识到看似不同的计算模型能够精确地解决同一类问题。研究了数十年的计算基本模型的意想不到的特征仍在被发现。例如,图灵机在多项式时间内可解的问题可以用某些类型的常微分方程的解来表征。计算视角的这种多样性非常重要,因为它关键地塑造了问题的表达和解决方式。

通过这个观点,我们有必要退后一步,确定神经计算的正确计算模型是什么。虽然当今的大规模 spiking 平台在某种意义上是图灵完备的,但神经形态硬件中强调的自下而上的功能与人工智能中使用的自上而下的算法之间存在明显的差异。这种脱节表明,通用图灵计算模型也许并不最适合描述大脑物理结构中出现的认知功能。虽然关于神经形态硬件是否比传统硬件具有优势的争论仍将继续,但我们认为,更富有成效的目标是确定神经计算的有效抽象模型。这样的抽象模型将使我们能够分析利用生物学新特征扩展神经拟态方法的潜在好处,并且有用的模型将使我们能够设计更广泛使用所需的有效编程模型。

图 1:不同学科对大脑有不同的看法。(来源:论文)

为神经形态计算设计计算模型提出了许多独特的挑战和陷阱。例如,突出神经形态计算优势的灵活模型应该能够解决模拟计算问题;然而,现实的连续计算模型的设计可能具有挑战性,并且可能会无意中引入在有限时间内解决不可计算问题的能力。然而,神经形态计算模型的设计者可能会从成功的连续计算模型中汲取灵感。神经形态计算也是大规模并行的,并使用异步通信(即没有全局时钟),因此直接与不考虑通信成本的传统算法进行比较可能是不公平的。在考虑神经形态计算方法相对于传统计算可能提供的潜在渐近优势时,公平和严格的比较至关重要。因此,传统计算的大规模并行或分布式模型可能是更好的比较候选者。使用公平指标进行比较也很重要,单位能量或空间计算等度量可能很有见地。

荷兰格罗宁根大学 Jaeger 和同事提出了一个替代框架来观察神经计算。从大脑在物理学中进行计算这一事实开始,物理学本质上是动态的和时空的,他们认识到适当的计算模型应该同样基于可以物理实现和观察的过程。这些想法并不一定是新的:控制论作为一个领域从计算的早期就已经存在;冯·诺依曼本人质疑串行编程模型是否非常适合描述类脑计算。Jaeger 及其同事提出的流畅计算模型建立在这些努力的基础上,结合了可组合性的实际优势即,用更简单的算法构建更复杂的应用程序的能力)和传统计算中固有的关联,这些约束来自神经系统的物理描述。

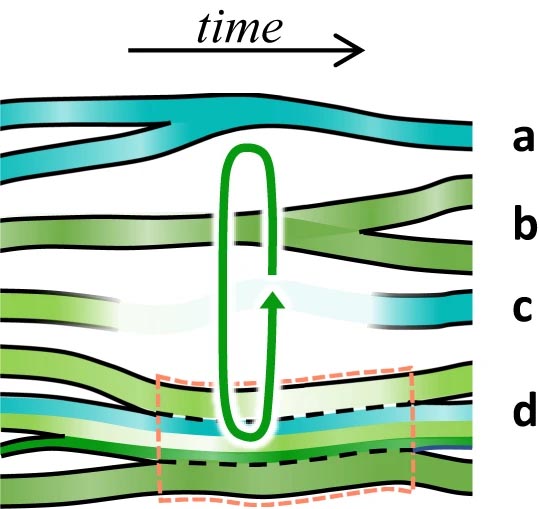

图 2:流畅计算(FC)建模中的动态重配置效应。(来源:Nat. Commun.)

研究人员长期以来一直在争论类脑计算是否应该通过算法计算或以物理为重点的计算来实现。与 Jaeger 和同事一样,作者选择稍微不同地解释这一点。为了让其他人能够编程和使用一个计算框架,它必须可以从自上而下的角度解释,但为了实现,所有框架都需要一个自下而上的组件。流畅计算方法的独特之处在于其作者专注于连接自下而上和自上而下的方法。通过跨尺度关联动态,所提出的流畅计算可以理想地实现传统算法设计中预期的可组合性。也许更令人兴奋的是,这种方法应该可以扩展到大脑中广泛的空间和时间动态,而这些动态在当今的神经计算中通常无法捕获。

重要的是要研究如何将神经形态计算的这种正式的自下而上的视角与神经形态计算的其他更多算法视角联系起来,例如人工神经网络,表征神经元组件或矢量符号架构。这些自上而下的模型提供了与算法设计的清晰联系以及与传统计算的比较,但在这样做的过程中,它们可能会消除使大脑具有强大计算能力的大部分物理原理。可以说,这些自上而下模型的普遍性也使得人们很容易忽视更深层次神经灵感的潜在贡献。通过构建,这些模型几乎可以解决任何问题,那么为什么要考虑神经生物学概念(例如调制或学习)引入的复杂性呢?大脑的存在必须受到空间和能量的限制,就像我们寻求开发的计算机和人工智能系统一样。将这些框架与计算的物理模型连接起来可能会提供一种机制来公平地评估这种复杂性所带来的影响,并进一步提供一种途径来理解当这些机制在伤害和疾病中被破坏时意味着什么。

退一步来说,挑战图灵计算模型作为描述神经计算的最有效模型不仅仅是理论计算机科学的一个哲学问题。它为整个神经科学领域提出了一个更基本的问题。在我们几十年来通过图灵计算和冯·诺依曼架构的镜头显式或隐式地描述大脑之后,也许值得一问的是,我们是否已经忽视了大脑的特殊之处。也许我们在不知不觉中抽象出了理解认知和智力所需的东西,并在这个过程中无意中束缚了自己,因为我们为了高效计算和改善健康而追求大脑。

「大脑使用算法吗?」 这不是一个正确的问题。正确的问题是,「我们是否能够理解神经算法到底是什么?」